023.12.9-混合专家模型

1、Mixtral 8x7B:MistralAI发布的混合专家模型

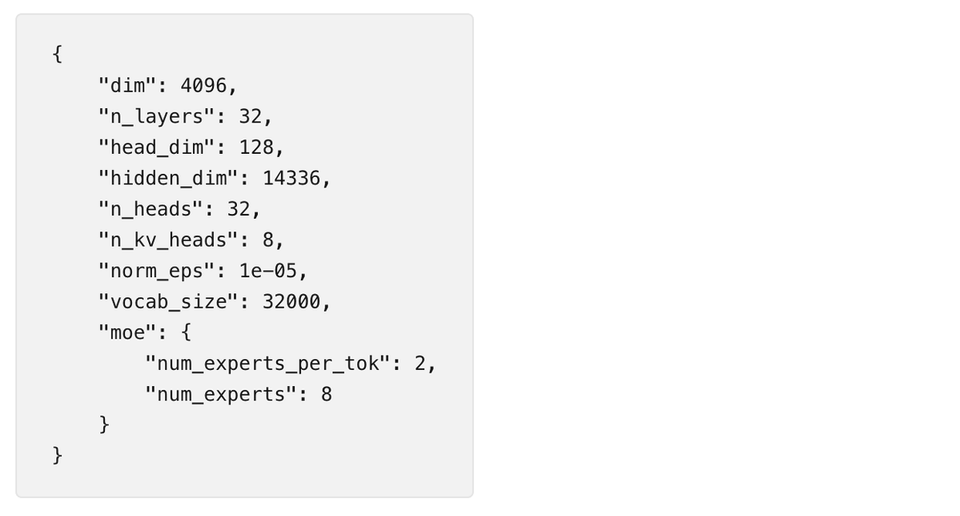

由8个7B模型混合的模型,即 mixture-of-experts (MoE),据说 GPT-4 使用的就是这种模型。

模型大小87G。

模型下载:https://huggingface.co/someone13574/mixtral-8x7b-32kseqlen

可能与其相关的Github:https://github.com/mistralai/megablocks-public

2、DynamiCrafter:图片生成视频的模型

10月份发布的论文,近期发布了源码。

项目地址:https://doubiiu.github.io/projects/DynamiCrafter/

Github:https://github.com/Doubiiu/DynamiCrafter

12月9日AI资讯

2023.12.9-混合专家模型

1、Mixtral 8x7B:MistralAI发布的混合专家模型

由8个7B模型混合的模型,即 mixture-of-experts (MoE),据说 GPT-4 使用的就是这种模型。

模型大小87G。

模型下载:https://huggingface.co/someone13574/mixtral-8x7b-32kseqlen

可能与其相关的Github:https://github.com/mistralai/megablocks-public

2、DynamiCrafter:图片生成视频的模型

10月份发布的论文,近期发布了源码。

项目地址:https://doubiiu.github.io/projects/DynamiCrafter/

Github:https://github.com/Doubiiu/DynamiCrafter

3、WonderJourney:能生成3D场景图片的框架

从给定图片或描述出发,可以生成任意角度移动的场景图片。图片质量看起来不是特别高。

项目地址:https://kovenyu.com/wonderjourney/

论文:https://arxiv.org/abs/2312.03884

效果演示: